četrtek, 08. januar 2026 leto 31 / št. 008

Strokovnjaki OZN: V Libiji domnevno prvič uporabljen leteči ubijalski robot, »kamikaza« z umetno inteligenco

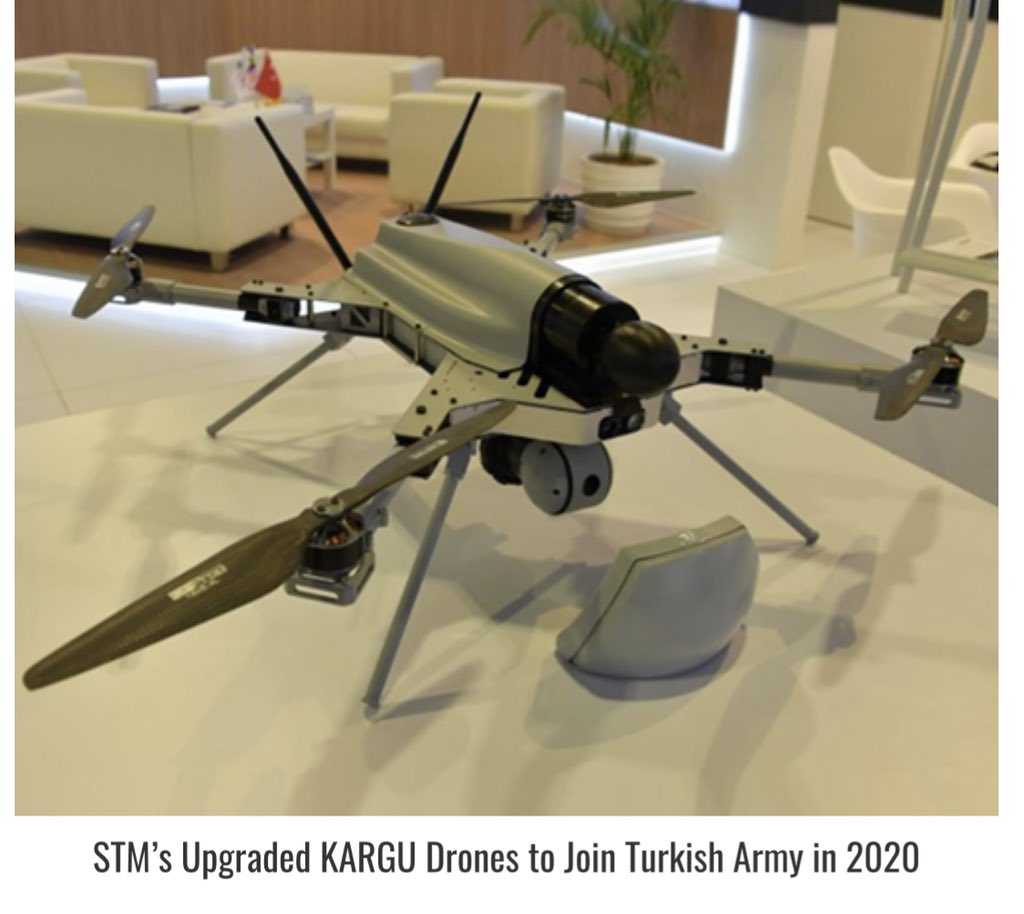

Kargu-2, dron z umetno inteligenco. Vir: Twitter

Kargu-2, dron z umetno inteligenco. Vir: Twitter

Lani je v Libiji avtonomno orožje turške izdelave - brezpilotni zrakoplov STM Kargu-2, domnevno »lovilo in na daljavo ubijalo« umikajoče se vojake, zveste libijskemu generalu Khalifi Haftarju.

Takšni so sklepi nedavnega poročila skupine strokovnjakov OZN o Libiji.

Če bodo sklepi tega poročila potrjeni, bi šlo za precej revolucionarno pa tudi naravnost grozljivo novost – prvič naj bi namreč o ubijanju drugih ljudi, nasprotnikov v vojni odločala umetna inteligenca in ne - vojaki.

Vse skupaj naj bi se dogajalo med umikom sil generala Khalife Haftarja, ki so morale po neuspešni ofenzivi na Tripoli, ki je propadla prav zaradi velike pomoči Turčije, zapuščati položaje in se umikati.

Vlada v Tripoliju, ki jo sicer priznavajo OZN, se je v veliki meri oprla prav na pomoč Ankare.

Hkrati pa so imele sile Haftarja oporo s strani ruskih najemniških vojakov, pa tudi Egipta, Združenih arabskih emiratov in še nekaterih držav.

Turčija je libijski vladi pomagala predvsem z brezpilotnimi letali, ki so se pokazali kot izjemno učinkoviti.

At least one European NATO country has been playing close attention to Turkey's battlefield success in Libya and Nagorno-Karabakh... https://t.co/l1YMRvDH4c

— François Heisbourg (@FHeisbourg) May 22, 2021

Med tem konfliktom pa so uporabili tudi dron Kargu-2, ki pa pomeni novo stopnico v spirali konfliktov: Gre za novo poglavje v uporabi avtonomnih orožij, kjer stroji izbirajo in uničujejo »človeške cilje« na podlagi umetne inteligence.

Kargu-2 je brezpilotni zrakoplov, ki svet okoli sebe analizira s pomočjo strojnega učenja.

Njegovi programi omogočajo tudi skupinsko sodelovanje in napadanje ciljev v »roju«, v katerem skupaj deluje 20 takšnih naprav.

Was a flying killer robot used in Libya? Quite possibly - Bulletin of the Atomic Scientists [Thebulletin]https://t.co/qD43UV1Wmo

— Rojname News English (@ROJNAME_english) May 21, 2021

Kako orožje deluje, kaže izdelovalec STM v videu, v katerem prikazuje napad na skupino lutk.

Brezpilotni dron najprej analizira situacijo, nato pa se usmeri proti središču skupine in eksplodira v zraku nad tlemi, tako da jeklene kroglice in drobci, ki jih raznese eksplozija, zadenejo in smrtno ranijo tudi večje število ljudi.

Dron namreč nosi v sebi majhno fragmentacijsko bojno glavo.

Kljub majhnosti je zaradi natančnega vodenja to orožje lahko izjemno nevarno.

Pri tem je dron tudi sam uničen in tako deluje kot nekakšni »robotski kamikaza.«

Doslej so mnogi vključno s Stevenom Hawkingom in Elonom Muskom opozarjali, da bi sami želeli prepovedati takšno orožje, ki bi lahko bilo najbolj nevarno človeštvu.

Nekateri trdijo, da bo takšno orožje nevarno, ker ne bo znalo razlikovati med civilisti in vojaki, drugi pa trdijo, da to ni res in da bo takšno orožje naredilo še manj »napak« ali zavestnih kršitev pravil bojevanja.

V številnih državah sveta že potekajo razprave o tem, ali bi bilo potrebno takšno orožje celo prepovedati.

KARGU (Autonomous Tactical Multi-Rotor Attack UAV) kamikaze (suicidal) drone.

— Libyan citizen- ﮼مواطن،ليبي (@Libyancitizen6) May 27, 2020

Was downed in Ain Zara.

Turkey is experimenting its rubbish in Libya. https://t.co/zgppNZnC86 pic.twitter.com/1e1kgqbzZt

Zastavlja se vprašanje, kakšno je tveganje, da bi ta orožja lahko naredila napake?

Kajti posledice bi lahko bile strahotne.

Posledice napačnega strela so lahko usodne za človeka, toda aktiviranje jedrske bojne glave W88 bi prineslo povsem drugačne posledice.

Calculating the Millions-High Death Toll of America’s Post-9/11 Wars

— Rodney Gee (@brolingo) May 22, 2021

(Nicolas JS Davies investigates the death toll of U.S. covert and proxy wars in Libya, Syria, Somalia and Yemen and underscores the importance of comprehensive war mortality studies.)https://t.co/0CsUwTwmpA

In kako se avtonomno orožje odloči, koga ubiti?

Mine - v določenem smislu izjemno preprosto avtonomno orožje - s pomočjo senzorjev tlaka določajo, kdaj naj eksplodirajo.

Sprožilec se lahko nastavi tako, da ga teža lažjega otroka ne sproži, odraslega človeka pa.

Tudi radarske rakete že znajo ločiti med civilnimi in vojaškimi radarji.

#Libya #Libia Foreign presence in terms of UNOFFICIAL military assets on the ground & OFFICIAL military bases and assets. Main actors: #Italy, #Russia, #Turkey, #Egypt, #EAU, #USA, #UK, #France, #Greece, #Germany, #Qatar pic.twitter.com/c0ZEtES1CI

— Federico (@FedericoIacop) May 22, 2021

In vojska Južne Koreje v demilatirizirani coni uporablja avtonomno orožje SGR A-1, ki lahko deluje čisto samo. Vendar ne vedno.

Problematično pa ostaja predvsem odločanje orožij na podlagi strojnega učenja, ki temelji na algoritmih, kot v Kargu-2.

Programe za računalniški vid je že mogoče usposobiti za prepoznavanje šolskih avtobusov, traktorjev in cistern.

Was a flying killer robot used in Libya? Quite possiblyhttps://t.co/86ZIK3QiDd

— Deb (@Justustalking2) May 20, 2021

Toda nabori podatkov, na katerih se učijo, morda niso dovolj zapleteni ali trdni, umetna inteligenca (AI) pa se lahko »nauči« tudi kakšne napačne lekcije.

V enem primeru je neko podjetje razmišljalo o uporabi umetne inteligence za sprejemanje odločitev o zaposlovanju, dokler vodstvo ni ugotovilo, da njihov računalniški sistem meni, da je najpomembnejša kvalifikacija kandidatov za službo, da jim je ime Jared in da so že igrali srednješolsko igro lacrosse, najstarejšo igro v Severni Ameriki, podobni kriketu.

Res odbito. Toda rezultati sploh ne bi bili komični, kot v opisanem primeru, če bi avtonomno orožje naredilo podobno napako!

Doslej je vsa avtonomna orožja še vedno nadzoroval človek, ki je imel možnost, če bi se situacija zasukala v napačno smer, da intervenira in napako še pravočasno odpravi.

Toda kot je razvidno iz poročila o uporabi Kargu-2, lahko takšni sistemi delujejo tudi brez kakršnegakoli nadzora.

Missy Cummings, direktorica človeškega in avtonomnega laboratorija na Univerzi Duke opozarja, da so tisti vozniki, ki menijo, da so njihova vozila bolj sposobna od njih samih, nagnjeni k večji raztresenosti in imajo zato »večjo možnost, da so udeleženi v nesrečah.«

Roboti, ki bodo sami odločali, kdaj ubiti ljudi so zato naslednja stopnja nevarnosti, ki je pred nami.

Death from the sky? Flying Killer Robots used #Libya according to the #UN. @ScharSchool's @ZKallenborn op-eds @BulletinAtomic about this new technology. "Governments at the UN are debating whether new restrictions on combat use... are needed." https://t.co/uWF8KP4zj2 pic.twitter.com/Y0hBOV42RI

— Schar School (@ScharSchool) May 20, 2021

In povsem mogoče je, da je bila nevarna meja odločanja prvič prestopljena nekje daleč od opazovalcev, v kaosu državljanske vojne, ki od intervencije zveze NATO leta 2003 divja v uničeni Libiji.